بلاگ

جمعآوری و استخراج اطلاعات از سایت: روشهای نوین و کارآمد

بهترین روشها برای دستیابی به اطلاعات از سایتها

در دنیای دیجیتال امروز، اطلاعات به ارزشمندترین دارایی سازمانها و افراد تبدیل شده است. با رشد روزافزون حجم اطلاعات در وب، نیاز به روشهای کارآمد و سریع برای جمعآوری و استخراج دادهها از سایتها بیش از پیش احساس میشود. در این مقاله، به بررسی جدیدترین روشها و ابزارهای مورد استفاده در این زمینه خواهیم پرداخت.

چرا جمعآوری و استخراج اطلاعات مهم است؟

جمعآوری و استخراج اطلاعات از سایتها، به عنوان یکی از روشهای کلیدی در تحقیقات بازار، توسعه محصول و تصمیمگیریهای استراتژیک، نقش بسیار مهمی ایفا میکند. این فرآیند به سازمانها و افراد اجازه میدهد تا به حجم عظیمی از دادههای ارزشمند دسترسی پیدا کرده و از آنها برای بهبود عملکرد خود بهرهبرداری کنند.

در ادامه به برخی از مهمترین دلایل اهمیت این موضوع اشاره میکنیم.

- تحلیل دقیق بازار: با جمعآوری اطلاعات از سایتهای رقبا و مشتریان، میتوان به درک عمیقتری از بازار هدف دست یافت. این اطلاعات به سازمانها کمک میکند تا موقعیت رقابتی خود را ارزیابی کرده و استراتژیهای موثرتر برای ورود به بازارهای جدید یا تقویت حضور خود در بازارهای موجود اتخاذ کنند.

- بهبود محصولات و خدمات: تحلیل نظرات و بازخوردهای مشتریان، به شرکتها کمک میکند تا نقاط قوت و ضعف محصولات و خدمات خود را شناسایی کرده و بهبودهای لازم را در آنها ایجاد کنند. این امر منجر به افزایش رضایت مشتری و در نهایت موفقیت تجاری میشود.

- توسعه تحقیقات علمی: محققان با استفاده از این روشها میتوانند به حجم عظیمی از دادههای مورد نیاز برای تحقیقات خود دسترسی پیدا کنند. این دادهها به آنها کمک میکند تا فرضیههای خود را آزمایش کرده و به کشفیات جدید دست یابند.

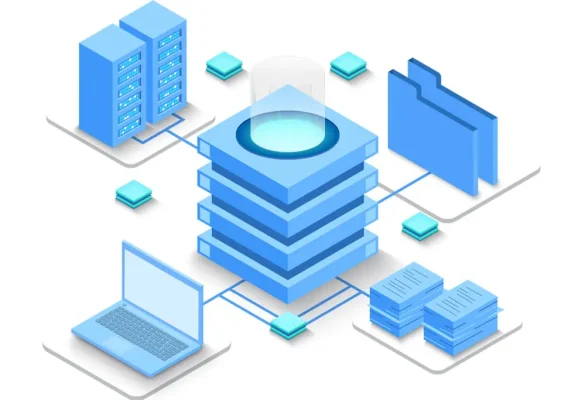

- ایجاد پایگاههای داده: اطلاعات جمعآوری شده از سایتها میتوانند برای ایجاد پایگاههای داده بزرگ و پیچیده مورد استفاده قرار گیرند. این پایگاههای داده به سازمانها اجازه میدهند تا تحلیلهای پیشرفتهای را بر روی دادهها انجام داده و به بینشهای ارزشمندی دست یابند.

همچنین افراد با جمعآوری اطلاعات با استفاده از دادههای دقیق و به روز میتوانند تصمیمهای آگاهانهتری بگیرند، با درک بهتر نیازها و انتظارات مشتریان تجربه مشتری را بهبود ببخشند و با شناسایی فرصتهای جدید در بازار نوآوری کنند و در نهایت به بهبود عملکرد کلی کسبوکار خود کمک کنند.

روشهای سنتی جمعآوری اطلاعات

در گذشته، جمعآوری اطلاعات عمدتاً به صورت دستی انجام میشد. این روشها شامل کپیبرداری و یادداشتبرداری از صفحات وب بود که زمانبر و مستعد خطا بود. با رشد تکنولوژی و افزایش نیازها، این روشها دیگر پاسخگوی نیازهای مدرن نیستند. لذا ابزارهای خودکار جایگزین شدند که دقت و سرعت کار را بهبود بخشیدند.

روشهای نوین جمعآوری و استخراج اطلاعات

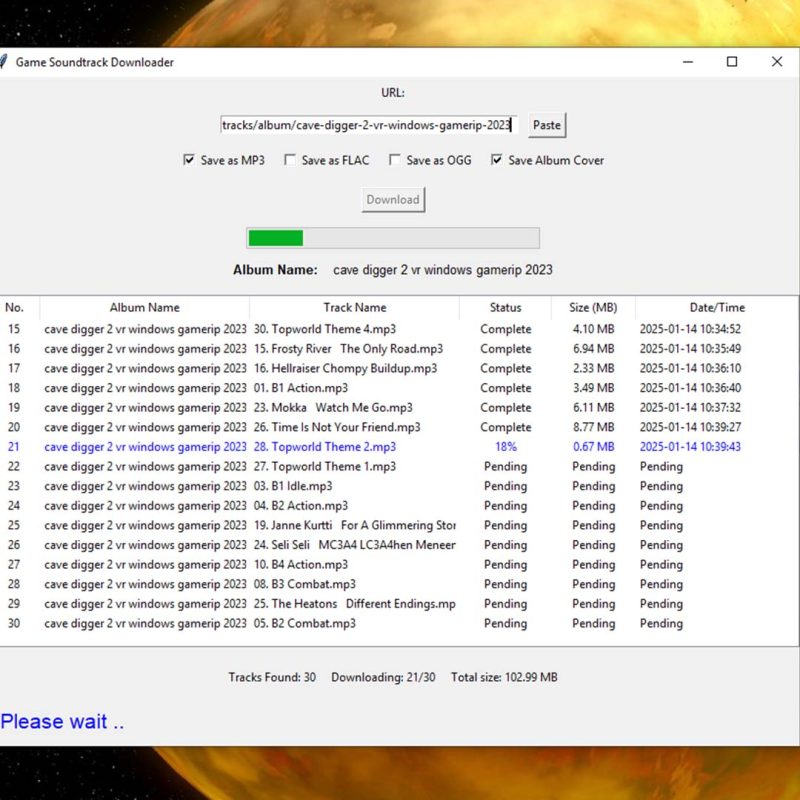

- وب اسکرپینگ (Web Scraping) فرآیند خودکار استخراج دادههای ساختار یافته از صفحات وب است. ابزارهایی مانند Beautiful Soup و Scrapy برای این کار بسیار کاربردی هستند. با این حال، برخی سایتها با استفاده از روشهای مختلف از این کار جلوگیری میکنند.

- APIها رابطهای برنامهنویسی هستند که به برنامهها اجازه میدهند با یکدیگر ارتباط برقرار کنند و به دادههای ساختار یافته دسترسی پیدا کنند. اگرچه استفاده از APIها آسانتر از وب اسکرپینگ است، اما نیاز به دانش برنامهنویسی دارد و ممکن است محدودیتهایی در حجم درخواستها وجود داشته باشد.

- نرمافزارهای تخصصی مانند Import.io و ParseHub به طور خاص برای جمعآوری و استخراج داده از وب طراحی شدهاند. این نرمافزارها معمولاً رابط کاربری سادهای دارند و امکانات متنوعی را برای کاربران فراهم میکنند.

- یادگیری ماشین به الگوریتمهایی گفته میشود که میتوانند از دادهها یاد بگیرند و برای انجام وظایفی مانند تحلیل احساسات یا تشخیص موجودیتهای نامدار استفاده شوند. این روش برای استخراج اطلاعات از متنهای غیرساختار یافته بسیار مفید است، اما نیاز به دادههای آموزشی بزرگ و پیچیدگی پیادهسازی دارد.

ابزارهای کارآمد برای جمعآوری و استخراج اطلاعات

Any Extract : یک ربات جمعآوری و استخراج اطلاعات از سایت که به وسیله آن میتوانید نام، قیمت، دسته، فروشنده، گارانتی، توضیحات، نقد و بررسی، وضعیت فروش، موجودی، لینک، فهرست، مسیر، نام سایت، عکس شاخص، گالری تصاویر و … را به راحتی استخراج کرده و خروجی نهایی را در یک لینک csv دریافت کنید.

Beautiful Soup : یک کتابخانه پایتون برای وب اسکرپینگ که دادهها را از صفحات HTML و XML استخراج میکند. این ابزار برای پروژههای کوچک و متوسط بسیار مناسب است.

Scrapy : با Scrapy، شما میتوانید به راحتی دادهها را از پیچیدهترین وبسایتها و بزرگترین پروژهها استخراج کنید. این فریمورک پیشرفته، ابزارهای قدرتمندی را در اختیار توسعهدهندگان قرار میدهد تا بتوانند اطلاعات مورد نیاز خود را به صورت خودکار جمعآوری کنند.

Octoparse : یک ابزار بدون نیاز به کدنویسی که امکان طراحی رباتهای اسکرپینگ برای استخراج دادهها از وبسایتها را فراهم میکند.

ParseHub : یک ابزار کاربرپسند است که به شما اجازه میدهد بدون نیاز به دانش برنامهنویسی، دادهها را به سادگی از وبسایتهای پیچیده استخراج کنید. با استفاده از رابط گرافیکی این ابزار، میتوانید به سرعت رباتهای وب اسکرپینگ را طراحی و اجرا کنید.

Google Sheets : با استفاده از افزونههایی مانند ImportXML و APIهای مختلف، میتوان دادهها را به راحتی به صفحات گسترده وارد کرد.

چالشها و راهکارها در جمعآوری اطلاعات

در ادامه، به بررسی چالشهای پیش رو در فرایند جمعآوری و استخراج دادهها و راهکارهای موثر برای غلبه بر این موانع میپردازیم.

چالشها

- محدودیتهای قانونی: برخی از وبسایتها سیاستهای سختگیرانهای در مورد استفاده از دادههای خود دارند.

- تغییر ساختار وبسایت: تغییرات در طراحی و کدنویسی وبسایتها میتواند باعث اختلال در اسکرپینگ شود.

- حجم بالای دادهها: مدیریت و ذخیرهسازی حجم بالای دادهها چالشی جدی است.

راهکارها

- رعایت قوانین و دریافت مجوزهای لازم برای جمعآوری دادهها.

- استفاده از ابزارهای پویا که میتوانند به تغییرات وبسایتها پاسخ دهند.

- بهرهگیری از خدمات ابری برای ذخیرهسازی و پردازش دادهها.

سخن آخر

جمعآوری و استخراج اطلاعات از سایتها، یکی از مهارتهای ضروری در دنیای دیجیتال امروز است. با انتخاب روش و ابزار مناسب، میتوان به حجم عظیمی از دادههای ارزشمند دسترسی پیدا کرد و از آنها برای بهبود تصمیمگیری و پیشرفت کسبوکار استفاده کرد. با ربات استخراج اطلاعات به راحتی میتوانبد این کار را عملی کنید.